Ce chapitre présente l'éventail des pratiques d'évaluation utilisées par les organisations internationales. Les OI évaluent principalement des instruments individuels plutôt que des sous-ensembles ou le stock global, mènent des évaluations ex post plutôt qu'ex ante, et évaluent la mise en œuvre plus souvent que l'impact. Il existe un engagement de plus en plus répandu en faveur de l'amélioration de l'évaluation parmi les OI. Cela se reflète par une série de principes clés, qui visent à institutionnaliser, développer et guider les activités d'évaluation, tout en élargissant leur portée, ainsi qu’en publiant et en agissant de manière transparente leurs résultats. Mener une évaluation peut nécessiter beaucoup de ressources, être méthodologiquement difficile et politiquement sensible. Les OI adoptent des mesures innovantes pour surmonter ces obstacles, notamment en renforçant l'interface avec leurs membres et en déployant les technologies numériques et les sources d'information.

Recueil de pratiques des organisations internationales

3. Développer la culture de l’évaluation des instruments internationaux

Abstract

Introduction

L’évaluation des instruments internationaux peut fournir de précieuses informations sur leur mise en œuvre et leurs impacts. Elle améliore in fine le processus d’élaboration des normes internationales, et ce à plusieurs niveaux : elle accroît la qualité des instruments internationaux et constitue un outil essentiel pour faire en sorte que ces derniers restent adaptés à leur finalité, c’est-à-dire qu’ils continuent à atteindre leurs objectifs et à répondre aux besoins de leurs groupes cibles. L’évaluation peut également contribuer à promouvoir l’adoption des instruments internationaux à plus grande échelle et à renforcer la confiance dans les OI et leurs pratiques.

« L’évaluation » dont il est question ici ne porte pas sur la qualité des dispositions des instruments internationaux (ce qui consisterait à déterminer s’ils établissent des règles claires et détaillées), mais plutôt sur leur efficacité, leur utilisation ou leur mise en œuvre, ou encore leurs effets. Cet examen implique souvent la collecte et l’analyse de données relatives aux instruments et notamment : les pratiques dont ils traitent, leurs utilisateurs (qui s’en sert, pourquoi et comment), les avantages et inconvénients (escomptés ou inattendus) de leur utilisation et le degré de réalisation de leurs objectifs dans la pratique. Les OI recueillent tout un éventail de données au sujet de leurs instruments et les informations ainsi générées sont fonction de la nature de chacun (voir chapitre 1).

Les OI ont de plus en plus à cœur de renforcer la culture de l’évaluation des instruments internationaux, bien qu’elles considèrent généralement celle-ci comme une entreprise ardue et grande consommatrice de ressources. En effet, même si les OI disposent de l’expertise et des ressources techniques nécessaires pour évaluer leurs instruments, ce ne sont pas elles qui détiennent les informations détaillées sur leur mise en œuvre et leurs impacts, ni la connaissance de leur cohérence avec les cadres réglementaires nationaux, mais les groupes cibles dans les différents pays (OCDE, 2016[1]). Les OI peuvent également rencontrer des difficultés d’ordre méthodologique, par exemple pour isoler et mesurer les effets de leurs instruments.

Cette partie du recueil entend guider les pratiques d’évaluation des OI en présentant les diverses approches possibles, ainsi que leurs avantages et les problèmes qu’elles posent. La discussion porte sur les évaluations menées par les OI elles-mêmes (les évaluations des instruments internationaux par d’autres organisations n’étant pas prises en compte)1 et repose principalement sur les pratiques existantes des OI, recueillies dans le cadre du Partenariat des organisations internationales.

Motivations

Les OI évaluent leurs instruments pour des raisons très diverses, et notamment pour accompagner leurs initiatives de promotion de ces derniers ou encourager leur mise en œuvre et leur utilisation, pour estimer les besoins d’assistance de leurs membres, apprécier les niveaux de conformité et intégrer les résultats des évaluations aux procédures de suivi (voir chapitre).

L’évaluation peut également contribuer à l’amélioration des instruments internationaux en mettant en avant les éléments à actualiser. De manière générale, elle peut aider les organismes qui établissent des règles au niveau international à faire le bilan des coûts et des avantages liés à leurs instruments (Parker and Kirkpatrick, 2012[2]). Elle facilite l’étude de la répartition de ces coûts et avantages et permet de déterminer si les bénéfices sont supérieurs aux coûts et s’il existe des différences d’impact selon les membres.

L’évaluation peut présenter encore plus d’avantages si elle est menée sur un ensemble ou sous-ensemble d’instruments et la coopération avec d’autres OI actives dans les domaines concernés peut enrichir ses résultats s’il existe des complémentarités entre les instruments.

Les analyses d’impact ex ante constituent un moyen de clarifier les objectifs et la fonction des instruments internationaux avant d’engager le processus d’élaboration des règles, au service de l’efficacité et de l’efficience. Elles incitent les responsables de l’élaboration des règles à étudier toutes les pistes possibles – y compris celle de l’inaction – en amont de l’adoption des instruments (OCDE, 2020[3]) et facilitent également à ce stade l’examen systématique des coûts et effets négatifs potentiels des instruments, en vue de leur éventuelle atténuation (OCDE, 2020[3]).

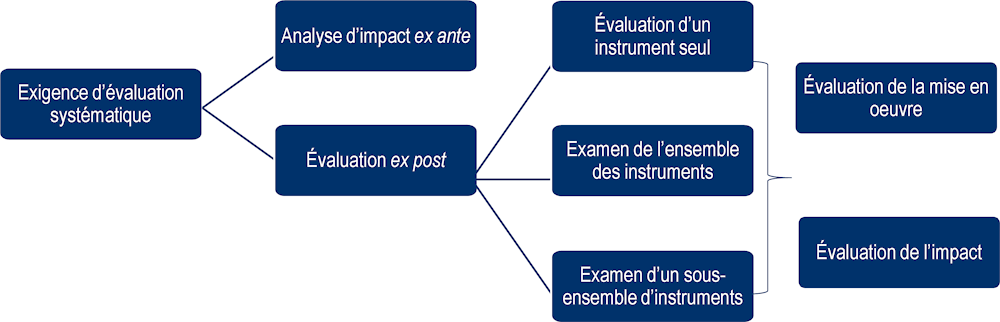

Typologie : mécanismes d’évaluation

Cette partie recense les mécanismes existants en matière d’évaluation des instruments internationaux en prenant appui sur la typologie présentée dans la brochure (OCDE, 2019[4]) et les réponses à l’enquête de 2018. La typologie suivante permet au lecteur de se faire une idée des diverses formes d’évaluation mises en œuvre par les OI membres du Partenariat des OI. Elle est fournie à titre indicatif seulement et ne brosse donc pas nécessairement un panorama exhaustif des pratiques possibles.

Graphique 3.1. Pratiques actuelles des organisations internationales en matière d’évaluation

Source : The Contribution of International Organisations to a Rule-Based International System, (OCDE, 2019[4]).

Tableau 3.1. Pratiques actuelles des organisations internationales : tour d’horizon des avantages et des problèmes posés

|

Description |

Avantages |

Problèmes posés |

|

|---|---|---|---|

|

Analyse d’impact ex ante |

Examen des incidences sociales, économiques et environnementales attendues des instruments avant leur adoption. |

Orientation et planification stratégique, améliore l’allocation des ressources, permet d'anticiper les besoins en données et d’établir des points de référence pour le suivi ex post. |

Recours à des estimations et projections, sensible aux incidences non prévues. |

|

Évaluation ex post |

Évaluation rétrospective des incidences des instruments internationaux. |

Boucle de rétroaction entre la mise en œuvre et l’élaboration de l’instrument, peut faire apparaître des problèmes de mise en œuvre qui n'avaient pas été anticipés. |

Absence éventuelle de données sur la situation initiale, dépendance à l’égard d’agences extérieures pour l’obtention d’informations, peut se heurter à une résistance plus grande que l’évaluation prospective et consomme beaucoup de ressources. |

|

Évaluation de l’utilisation ou de la mise en œuvre d’un instrument seul |

Examen axé sur l’utilisation et la mise en application. |

Simplicité de la méthodologie, permet le suivi des besoins en matière d’assistance, favorise la conformité, enrichit le travail de promotion de l’instrument, consomme moins de ressources que l’évaluation d'impact. |

Possibilités limitées d’exploitation dans le cadre des processus d’apprentissage de l’organisation. |

|

Évaluation de l’impact d’un instrument seul |

Analyse des résultats par rapport à un ensemble de critères, attention particulière portée à l’imputation et aux résultats/réalisations. |

Rigueur méthodologique et crédibilité des données, processus d’apprentissage plus robuste. |

Consommation importante de ressources, absence potentielle de mécanismes d’information/de contrôle pour mener ce type d’évaluation au niveau international, complexité de la méthodologie. |

|

Examen de l’ensemble des instruments |

Évaluation du produit de la réglementation dans son ensemble. |

Prise en compte globale des instruments, orientation stratégique globale, inventaire des domaines non couverts. |

Consommation importante de ressources, manque de profondeur de l'analyse sur certains sujets. |

|

Examen d’un sous-ensemble d’instruments |

Évaluation de tout un éventail d’instruments dans un secteur, un domaine d'élaboration de règles ou une initiative donnés. |

Rend compte des interactions entre divers instruments et de leurs effets cumulés, limite les doubles emplois. |

Difficultés éventuelles d’imputation des résultats. |

Source: établi par l’auteur à partir des informations communiquées par les OI.

Principes fondamentaux de l’évaluation

Cette partie expose les principes fondamentaux qui peuvent aider les OI à améliorer leurs pratiques d’évaluation. Ils sont tirés de l’expérience d’un grand nombre d’OI et s’appuient sur les documents Analyse d’impact de la réglementation (OCDE, 2020[3]) et Examiner la réglementation existante (OCDE, 2020[5]) de la série des Principes de bonne pratique de l’OCDE en matière de politique réglementaire, qui livrent une synthèse des pratiques nationales dans le domaine de l’évaluation de la législation et de la réglementation. Compte tenu de la diversité des OI et des types d’instruments normatifs qu’elles élaborent, ces principes ne seront pas nécessairement adaptés ou applicables à l’ensemble des OI. Celles qui le souhaitent pourront néanmoins y trouver une source d’inspiration et des orientations utiles pour développer leur culture de l’évaluation.

1. Institutionnalisation de l’évaluation des instruments

L’institutionnalisation de l’évaluation systématique des instruments normatifs élaborés par les OI est une mesure très utile pour s’assurer qu’ils demeurent pertinents. Son niveau de formalité peut varier – s’agissant de l’engagement en faveur de l’évaluation, elle pourrait par exemple se traduire par l’intégration des pratiques d’évaluation dans le règlement intérieur de l’OI ou la création d’un service à qui l’on confierait la réalisation des évaluations. Dans un cas comme dans l’autre, elle constitue une manifestation de la volonté des OI d’assurer l’amélioration continue de leurs instruments et de faire en sorte qu’ils restent adaptés à leur finalité.

Des processus d’évaluation clairement érigés en priorité, bien définis et accessibles (notamment sur la question de savoir qui est chargé de leur mise en œuvre et de leur supervision), peuvent contribuer à ancrer l’évaluation dans la culture et la pratique quotidiennes de l’organisation.

2. Des débuts à petite échelle et un développement progressif des pratiques d’évaluation

Les OI considèrent l’évaluation de leurs instruments comme une tâche ardue et délicate et ce, pour diverses raisons (voir partie 5). Il n’est d’ailleurs pas certain que tous les types d’instruments puissent être évalués avec succès. Si une catégorie d’instruments n’a jamais été soumise à évaluation, par exemple, et en l’absence de pratiques optimales facilement identifiables, il peut être judicieux d’apprécier dans un premier temps « l’évaluabilité » de l’instrument en question, compte tenu de ses objectifs et de la manière dont il est mis en œuvre et par qui, pour déterminer si l’évaluation sera possible et/ou utile. La plupart du temps, la réponse sera « oui », mais l’objet et l’étendue de l’évaluation pourront varier.

Le premier niveau d’évaluation des instruments internationaux consiste à examiner leur utilisation ou leur application – qui les met en œuvre, pourquoi, où, quand et comment (voir chapitre 2). Cette approche présente un intérêt particulier pour les instruments non contraignants.

Les OI n’ayant souvent aucun contrôle sur la mise en œuvre de leurs instruments, notamment lorsque ceux-ci ne sont pas contraignants, l’évaluation de leur utilisation n’est pas toujours aisée et il peut être difficile de recueillir des données complètes. Cela dit, même des données partielles peuvent fournir des informations extrêmement utiles susceptibles de donner lieu à une révision des instruments internationaux – ou à leur retrait – et aider les OI à mieux cibler et planifier le soutien qu’elles apportent pour faciliter la mise en œuvre de leurs instruments (voir chapitre 2). Il est également possible d’évaluer l’utilisation d’instruments internationaux qui n’ont pas été assortis d’objectifs clairement mesurables lors de leur conception.

Le second niveau d’évaluation des instruments internationaux consiste à examiner leurs incidences. Il s’agit d’une entreprise beaucoup plus complexe que l’évaluation de l’utilisation, posant de sérieux défis liés à la disponibilité des données, à la difficulté d’établir une causalité (p. ex. la part des résultats observés attribuable à l’instrument de l’OI par rapport à d’autres facteurs comme l’environnement favorable et les actions complémentaires d’autres parties prenantes) et la durée parfois nécessaire jusqu’à ce que le travail normatif ait un impact2. C’est ce qui explique entre autres pourquoi les OI ont généralement moins d’expérience dans la conduite de ce type d’évaluations. Nombre d’entre elles en ont toutefois conscience et essaient de trouver des moyens d’évaluer non seulement l’utilisation, mais également l’impact de leurs instruments. Il existe un large éventail de pratiques et de méthodologies efficaces en la matière et certaines OI ont élaboré des documents d’orientation pour aider d’autres organisations à évaluer avec efficacité l’impact de leurs instruments3. Les OI pourraient aussi envisager une collaboration avec d’autres acteurs comme les milieux universitaires ou les ONG si elles ne disposent pas de l’expertise technique requise en interne (voir chapitre 4).

Une culture de l’évaluation ne se construit pas du jour au lendemain. En commençant par des évaluations de moindre envergure aux objectifs modestes, on pourrait obtenir des résultats intermédiaires et s’en servir pour accroître la confiance dans les processus d’évaluation au sein de l’OI, ce qui pourrait faire naître une volonté d’aller plus loin par la suite. Même des volumes réduits de données et des résultats limités issus d’évaluations menées à plus petite échelle peuvent mettre en évidence des effets très positifs et inciter davantage de parties prenantes à mettre en œuvre les instruments internationaux (voir chapitre 2).

3. Élaboration d’orientations pour les responsables de l’évaluation

L’élaboration de documents d’orientation à l’intention des responsables de la planification ou de la conduite de l’évaluation contribuera à harmoniser les pratiques et à définir les attentes du point de vue de l’OI et de ses parties prenantes. L’adoption d’une approche commune revêt une importance particulière lorsque les évaluations sont menées de manière décentralisée (par exemple, par des membres ou des consultants externes et non par le Secrétariat de l’OI).

Les orientations pourraient notamment porter sur les points suivants :

la définition des objectifs : comment fixer des objectifs concrets et réalisables et établir des critères d’évaluation clairs et mesurables.

le choix des personnes qui procèderont à l’évaluation – aperçu des critères à remplir ou des qualifications requises pour entreprendre l’évaluation en question.

les coûts de l’évaluation – veiller à ce que le coût du processus d’évaluation soit proportionné aux effets attendus de l’instrument international.

l’évaluation comparative – lorsque cela est possible, envisager des analyses comparatives entre États.

la participation des intéressés – assurer une consultation ouverte et effective avec les parties prenantes et ceux qui seront concernés ou probablement concernés.

le recours aux technologies – réflexion sur les possibilités d’utilisation des technologies numériques pour accroître l’efficacité des processus d’évaluation et pour analyser ou collecter des données.

l’exploitation des données – tirer parti de toutes les sources d’information disponibles et envisager le recours à des sources moins classiques comme les informations de source ouverte, les données satellitaires, de téléphonie mobile, des médias sociaux, etc.

la confidentialité, l’impartialité et l’indépendance – réflexion sur les moyens de tenir compte de ces principes à toutes les étapes du processus d’évaluation.

4. Définition des objectifs par rapport auxquels les instruments internationaux seront évalués

Lorsque les instruments internationaux sont assortis d’objectifs clairement mesurables, ceux-ci constituent de précieux critères d’évaluation. Toutefois, si cette utilisation n’est pas envisageable ou n’apporte qu’une compréhension partielle de l’instrument, il sera important de fournir des descriptions qualitatives des impacts difficiles ou impossibles à quantifier, comme l’équité ou la justice. Selon la nature de l’instrument et le niveau d’évaluation prévu, les objectifs peuvent être spécifiques à un instrument donné ou s’appliquer à un ensemble ou à un type ou une classe d’instruments. Ils pourraient également être fixés ou modifiés par l’État ou par l’organisation qui met en œuvre l’instrument en fonction des circonstances locales.

En détaillant et en appliquant un processus rigoureux pour établir les objectifs des instruments internationaux – s’accompagnant par exemple de la collecte de données, d’études et de consultations avec les acteurs susceptibles d’être concernés par la mise en œuvre de l’instrument –, on peut contribuer à assurer la cohérence des objectifs entre les différents instruments d’une même OI. Cette façon de procéder permet également d’accroître la transparence du processus, voire de renforcer l’adhésion et la confiance accordée tant aux instruments eux-mêmes qu’aux pratiques d’évaluation qui se fonderont ensuite sur ces objectifs.

La définition d’objectifs doit faire partie du processus d’élaboration des instruments normatifs des OI (voir chapitre 1). Lorsque cela est possible, elle devrait être intégrée à la pratique plus générale d’établissement des objectifs et d’analyse d’impact ex ante (OCDE, 2020[3])4.

Avant d’élaborer un instrument, les OI ont en général la possibilité d’examiner les différentes options qui s’offrent à elles pour atteindre les objectifs fixés, ainsi que les effets de l’inaction. Elles devraient recueillir les données disponibles et faire appel à l’expertise scientifique et aux contributions des parties prenantes pour analyser l’ensemble des coûts et avantages potentiels (directs et indirects) de la mise en œuvre de l’instrument envisagé. Les résultats de cette analyse peuvent aider à améliorer le projet d’instrument, et leur communication au public (si possible) peut accroître la confiance dans les instruments internationaux ou, plus généralement, dans la culture de l’OI en matière d’évaluation, ainsi que l’adhésion des parties prenantes à ces derniers5.

5. Promouvoir l’évaluation de l’ensemble des instruments ou de sous-ensembles d’instruments

Les OI devraient envisager d’évaluer leurs instruments autrement qu’un par un. L’évaluation d’un sous-ensemble d’instruments ou de l’ensemble des instruments internationaux peut donner une orientation stratégique plus prononcée aux pratiques des OI en établissant un inventaire précis des divers instruments appliqués et en fournissant des indications sur ceux qui fonctionnent mieux que d’autres (OCDE, 2020[5]).

Les OI peuvent commencer par examiner une série d’instruments dans un secteur, un domaine d’action ou une initiative donnés, avant d’étendre progressivement leur analyse à une plus grande variété d’instruments. Ce travail permettra de repérer les lacunes qu’il pourrait être nécessaire de combler au moyen de nouveaux instruments internationaux ainsi que les chevauchements ou doubles emplois entre les instruments existants.

6. Transparence des processus d’évaluation et des résultats de l’évaluation

Il est important d’assurer le libre accès aux informations relatives aux processus d’évaluation et de diffuser en toute transparence les résultats des évaluations pour bâtir la confiance et montrer qu’il existe au sein de l’OI une solide culture de l’évaluation et de la responsabilité quant à ses instruments.

La consultation des principales parties prenantes à tous les stades du processus d’évaluation contribue pour beaucoup à la transparence et peut renforcer la crédibilité des résultats de l’évaluation (voir chapitre 4). Par ailleurs, la communication des projets de conclusions des exercices d’évaluation pour commentaires peut aider l’organe chargé de l’évaluation à consolider le corpus de données disponibles.

Les rapports d’évaluation devraient être diffusés aussi largement que possible, notamment au sein de l’OI et aux membres de l’OI, voire au grand public (sauf par exemple si cela pose des problèmes de protection ou de confidentialité des données pour les parties prenantes). La création d’un registre des résultats des évaluations passées (par exemple sur le site web de l’OI) peut être une solution. La transmission directe des rapports aux acteurs ayant participé au processus d’évaluation est également une bonne pratique (UNEG, 2014[6]).

7. Exploitation des résultats des évaluations

Au-delà de l’exploitation des résultats des évaluations, il faudrait que l’OI puisse montrer comment elle-même, ses organes directeurs, ses membres ou d’autres parties prenantes se sont servis de ces résultats pour :

Améliorer les instruments internationaux et/ou leur mise en œuvre, y compris pour combler les lacunes réglementaires dans l’ensemble d’instruments (voir chapitre 1).

définir des actions complémentaires concernant d’autres pratiques de l’OI et recenser les éléments à intégrer dans le cycle décisionnel suivant de l’OI.

déterminer quels sont, parmi les enseignements tirés du processus d’évaluation, ceux qui permettent d’améliorer ce processus (p. ex. amélioration des documents d’orientation, de la définition des objectifs ou de la communication des résultats).

Faire reconnaître l’utilité des instruments internationaux (voir chapitre 2).

État des lieux de l’évaluation des instruments internationaux

Évolution des pratiques des OI en matière d’évaluation

Recours aux pratiques d’évaluation

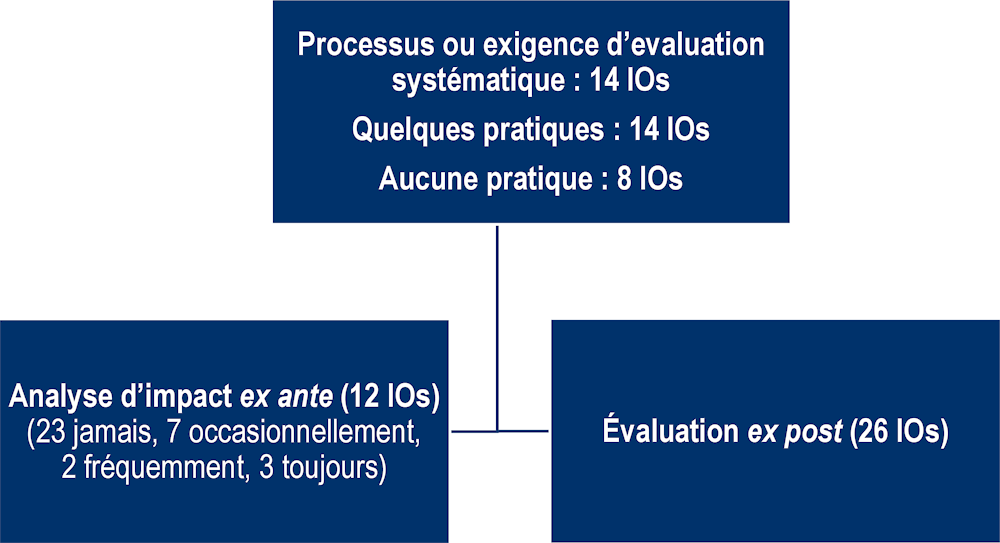

Les OI ont moins souvent recours à l’évaluation qu’aux autres activités décrites dans le présent recueil, mais elles sont de plus en plus nombreuses à adopter des pratiques en la matière. Dans l’enquête menée par l’OCDE auprès des OI en 2018, la grande majorité d’entre elles (28 sur 36) ont dit avoir mis en place un mécanisme d’évaluation, sous une forme ou une autre. Sur ces 28 OI, quatorze ont affirmé avoir l’obligation de conduire des évaluations de manière systématique. Seules huit OI ont indiqué n’avoir aucune pratique d’évaluation (Graphique 3.2).

Graphique 3.2. Typologie et exemples de mécanismes d’évaluation normatifs

Note : Nombre d’OI mentionnant ce type de mécanismes sur 36 réponses.

Source : Enquête OI 2018.

Un examen des différentes catégories d’OI6 montre clairement que ce sont les OIG à composition restreinte et fermée ou les secrétariats de conventions qui procèdent le plus fréquemment à des évaluations. Il s’agit probablement d’une question de formalisme des instruments utilisés (secrétariat des conventions) et de commodité de l’évaluation avec un nombre de membres limité (OIG « fermées »).

Lorsqu’elles se lancent dans l’évaluation, les OI se consacrent le plus souvent à l’évaluation de l’utilisation ou de la mise en œuvre des instruments internationaux, plutôt qu’à l’évaluation de leurs effets (OCDE, 2019[4]) (OCDE, 2016[1]). Plusieurs OI dont l’OIML et l’ISO disent examiner périodiquement, d’une manière ou d’une autre, l’utilisation ou la mise en œuvre de leurs instruments pour déterminer si ces derniers doivent être confirmés, révisés ou retirés. Le Secrétariat de la Convention sur la diversité biologique (CDB) est un exemple d’OI qui réalise des évaluations d’impact, sous la forme d’examens obligatoires de l’efficacité de ses instruments (les protocoles). Cela étant, même si la pratique est relativement peu utilisée, les OI et leurs groupes cibles reconnaissent la nécessité d’examiner les effets des instruments pour déterminer s’ils restent pertinents ou doivent être révisés. C’est le constat qui est ressorti très nettement de la deuxième réunion des organisations internationales7 et qui apparaît également dans les résultats de l’enquête de 2018.

Bien que toutes les catégories d’instruments soient évaluées, les résultats de l’enquête de 2018 montrent que les instruments le plus souvent examinés sont ceux que les OI qualifient de « normes ». Les normes techniques internationales, en particulier (p. ex. ASTM International, IEC, ISO) sont régulièrement évaluées pour assurer leur qualité, leur adéquation au marché et leur conformité avec l’état des connaissances du moment. Les évaluations de ce type ont souvent lieu de manière systématique et à une fréquence déterminée (p. ex. au moins tous les cinq ans). D’autres catégories d’instruments comme les conventions (p. ex. évaluation des six conventions culturelles par l’UNESCO) et même des instruments non contraignants (p. ex. mémorandums d’entente, etc.) font également l’objet d’évaluations, bien que moins fréquentes.

Institutionnalisation et gestion de l’évaluation

Dans l’enquête de 2018, sur l’ensemble des OI ayant indiqué avoir adopté un mécanisme d’évaluation, la moitié ont fait de l’évaluation une exigence systématique pour leurs instruments. Les autres n’ont pas défini d’exigence générale d’évaluation, ce qui signifie qu’une partie seulement de leurs instruments est soumise à évaluation ou que les évaluations n’ont lieu que ponctuellement. L’obligation d’évaluation peut être inscrite par exemple dans des clauses spécifiques intégrées aux instruments eux-mêmes ou dans des règlements, lignes directrices ou termes de référence plus généraux (voir chapitre 1).

L’existence d’une obligation de donner suite à l’évaluation d’un instrument international dépend souvent du résultat de celle-ci. Si un instrument est « confirmé », par exemple, aucune action ne sera peut-être requise. En revanche, des mesures supplémentaires seront nécessaires si l’évaluation aboutit à une proposition de « révision » ou de « retrait » de l’instrument. Dans certains cas, les OI se contenteront de recommander une action plutôt que de l’imposer à leurs membres.

La gestion des processus d’évaluation est souvent une compétence partagée entre le Secrétariat de l’OI et ses membres. Les réponses à l’enquête montrent que cette responsabilité partagée est systématique dans certaines OI, tandis que dans d’autres, elle fait l’objet de décisions au cas par cas, pour chaque instrument.

Les entités chargées de l’évaluation sont, dans certaines OI, les comités techniques responsables du développement de l’instrument. Cela vaut notamment pour les organisations de normalisation. D’autres OI disposent d’un organe ou d’un service permanents dédiés à l’évaluation des instruments, par exemple une unité de gestion/chargée de la politique globale ou le service qui a élaboré l’instrument. La gestion de l’évaluation relève quelquefois de la responsabilité de groupes de travail ad hoc, de comités directeurs ou de conseils de la présidence. L’évaluation n’est sous-traitée à un organisme extérieur que dans de très rares cas.

Encadré 3.1. Exemples d’évaluations systématiques menées par les OI

L’OCDE intègre systématiquement dans ses instruments juridiques des clauses demandant à l’organe compétent de promouvoir la mise en œuvre et la diffusion de l’instrument et de veiller à ce qu’il reste pertinent, notamment en faisant rapport au comité directeur (« Conseil de l’OCDE ») cinq ans après son adoption. Ces dispositions chargent souvent l’organe compétent de consulter d’autres organes (au sein et en dehors de l’OCDE) et de servir d’enceinte d’échange d’informations et d’évaluation des progrès réalisés par rapport aux indicateurs de référence. La communication d’informations au comité directeur vise à évaluer l’utilité de l’instrument plutôt que la mise en œuvre de ce dernier par les Parties (OCDE, 2014[7]).

Le mécanisme d’examen des normes (MEN) de l’OIT (OIT, 2011[8]) a été mis en place pour s’assurer que l’organisation dispose d’un corpus de normes internationales du travail solide, clairement défini et à jour. Le groupe de travail tripartite du MEN examine les normes et formule des recommandations sur a) leur statut, ce qui inclut les normes « à jour », les normes « devant être révisées », les normes « dépassées » et d’autres classifications éventuelles ; b) les lacunes dans la couverture, y compris celles nécessitant de nouvelles normes ; (c) les mesures de suivi concrètes à adopter le cas échéant, assorties de délais de mise en œuvre.

Source : Synthèse établie par l’auteur sur la base des réponses à l’enquête OI 2018.

Type d’évaluation (évaluation ex ante et ex post ; instrument unique/sous‑ensemble/ensemble) et outil (manuel/enquête en ligne, outil analytique)

Il existe une tendance marquée des OI à évaluer leurs instruments ex post, plutôt qu’ex ante (Graphique 3.2). Dans l’enquête de 2018, seules douze OI ont dit procéder à des analyses d’impact ex ante et parmi elles, la plupart ne le font pas régulièrement (trois seulement ont affirmé qu’elles réalisent systématiquement une évaluation ex ante, et deux qu’elles le font fréquemment). Lorsque l’évaluation a lieu ex post, elle porte généralement sur un instrument seul plutôt que sur l’ensemble des instruments (OCDE, 2016[1]). Nombre de processus d’évaluation ex post des OI sont assortis de délais, les dispositions des instruments imposant souvent un examen des instruments cinq ans après leur adoption.

Encadré 3.2. Exemples de modalités d’évaluation ex ante appliquées par les OI

La Structure de l’arrangement de reconnaissance mutuelle de l’ILAC (Mutual Recognition Arrangement, MRA) et la procédure d’extension du champ de l’arrangement ILAC (ILAC - R6:05/2019) (ILAC, 2019[9]) établissent un cadre pour l’intégration d’activités d’évaluation de la conformité, de documents normatifs et de publications sectorielles dans le champ d’application du MRA de l’ILAC, instrument clé pour les organismes concernés. Ce processus comprend plusieurs étapes et commence par la formulation d’une proposition d’extension du champ de l’arrangement, qui est ensuite examinée et approuvée avant d’être développée concrètement et finalement lancée. L’extension peut être proposée par les associations d’organismes d’évaluation de la conformité (OEC), le secteur privé et les associations professionnelles, les autorités de régulation, les organismes de coopération régionale reconnus et les différents organismes d’accréditation. L’évaluation comporte un examen des éléments d’appréciation disponibles concernant la nécessité de couvrir un nouveau domaine, une analyse des conséquences d’une couverture incomplète, ainsi que le recueil d’avis et la conduite de consultations avec les parties concernées. Il en découle une approche globale de l’élaboration de normes internationales qui combine et met à profit les avantages simultanés de l’élaboration d’instruments (WG1), de la participation des intéressés (WG3) et de l’évaluation (W4), tout en améliorant les interactions entre l’ILAC et ses membres.

Encadré 3.3. Exemples de modalités d’évaluation ex ante appliquées par les OI (suite)

En vertu de l’Accord interinstitutionnel « Mieux légiférer » au sein de l’Union européenne (Commission européenne, 2016[10]), la Commission européenne (CE) exige la réalisation d’une analyse d’impact de ses propositions de réglementation ayant une incidence économique, environnementale ou importante dans l’UE. La Commission publie une analyse d’impact initiale qui expose le problème et procède à une première évaluation des incidences attendues. À l’issue d’une consultation publique sur cette analyse d’impact initiale, la Commission mène une analyse d’impact complète de la réglementation, englobant une collecte de données et d’informations et des consultations publiques. Après examen des analyses d’impact par le Comité d’examen de la réglementation, une révision des projets de réglementation peut être nécessaire. Au niveau de la législation de l’Union, il est beaucoup plus probable qu’une analyse d’impact de la réglementation soit requise pour la transposition des directives de l’UE que pour servir de fondement à la position de négociation des différents États membres. Lorsque les États membres n’ont pas d’obligation formelle de mener une analyse d’impact de la réglementation durant la phase de négociation, ils s’appuient en général – mais pas de manière systématique – sur celles de la Commission européenne.

L’Organisation maritime internationale (OMI) soumet quelquefois sa réglementation à une analyse d’impact ex ante (OCDE, 2014[11]), notamment lorsqu’elle aborde des questions controversées ou complexes sur lesquelles il existe des divergences de vues. L’analyse des effets probables et potentiels des réglementations, ainsi que de leur étendue, permet de renforcer la légitimité des projets et de trouver un accord dans les domaines où des difficultés se présentent. L’organisation a ainsi publié diverses études de faisabilité et analyses d’impact portant sur des mécanismes de marché destinés à réduire les émissions de gaz à effet de serre des transports maritimes. Lors de l’examen de l’Indice nominal de rendement énergétique (Energy Efficiency Design Index, EEDI) et du Plan de gestion du rendement énergétique du navire (Ship Energy Efficiency Management Plan, SEEMP) avant leur adoption, il a été estimé dans les scénarios à hypothèse haute que l’application de ces instruments entraînerait à la fois une réduction des émissions globales de 330 millions de tonnes en moyenne (40 %) par an d’ici 2030 par rapport au statu quo et une hausse des économies dans le secteur du transport maritime de 310 milliards USD par an. On se situe ici à l’intersection entre différents aspects de la réglementation internationale, l’analyse d’impact ex ante pouvant être en même temps un élément central du processus d’élaboration des instruments, un mécanisme de promotion et de conformité et une forme d’évaluation (voir chapitres 1 et 2).

En vertu de la Convention instituant une Organisation internationale de métrologie légale (OIML, 1955[12]), tout nouveau projet, y compris l’élaboration de nouvelles normes internationales, fait l’objet d’un examen par l’OIML avant d’être soumis pour approbation. Cet examen porte sur un certain nombre d’éléments clés et notamment : les raisons qui ont conduit à proposer une publication de l’OIML dans le domaine en question, le champ d’application envisagé du projet de publication, les raisons d’une réglementation de cette catégorie d’instruments, des précisions concernant les pays qui réglementent déjà cette catégorie d’instruments ou ont exprimé leur intention de le faire, une description des travaux similaires en cours au sein d’autres organisations (s’il y a lieu) et les coordonnées des organismes de liaison potentiels. Dans les deux derniers cas, l’OIML adopte une approche intégrée de l’évaluation et de la coordination (voir chapitres 3 et 5 ). Cette forme de tour d’horizon peut élargir la base de connaissances et d’expertise contribuant à l’élaboration de nouveaux instruments, permettre une allocation efficace des ressources et limiter les doubles emplois inutiles. Ces éléments et d’autres sont passés en revue avant la présentation du projet aux États membres pour approbation.

Source : (OCDE, 2019[13]) ; (OCDE, 2014[11]) ; synthèse établie par l’auteur sur la base des réponses des OI à l’enquête de 2018 et des contributions reçues des OI.

Dans les organisations internationales qui pratiquent régulièrement l’évaluation, la forme d’examen la plus courante est l’analyse d’instruments seuls. D’après les résultats de l’enquête de 2018, deux OI sur trois évaluent l’utilisation, la mise en œuvre ou l’impact d’instruments pris individuellement. Dans ce groupe, les organisations internationales de normalisation privées se distinguent par le caractère méthodique de l’évaluation, son étendue et son format, ainsi que son intégration au développement des instruments (Encadré 3.4, voir chapitre 1). L’uniformité de cette pratique est un exemple de processus d’apprentissage mutuel entre OI et ouvre de nouveaux espaces de coordination (voir chapitre 5). Au-delà de l’OCDE, les organisations intergouvernementales ne reproduisent pas ces formes d’évaluation. Il n’y a toutefois aucune raison institutionnelle impérative à cela et les organisations internationales pourraient envisager d’intégrer dans leurs instruments des exigences minimales similaires en matière d’évaluation.

Encadré 3.4. L’examen systématique des normes : un modèle reproductible ?

La procédure d’examen des normes ASTM (https: et al., 2020[14]) consiste à soumettre toutes les normes à un examen complet par le sous-comité compétent, puis à un vote en vue de leur revalidation, de leur révision ou de leur retrait, dans les cinq ans après la validation la plus récente. Si une norme n’est pas revalidée au 31 décembre de la huitième année suivant la précédente date de validation, elle est retirée.

Toutes les normes internationales de l’IEC sont passées en revue conformément aux procédures de maintenance des livrables contenues dans les Directives ISO/IEC Partie 1 + supplément IEC (ISO/CEI, 2018[15]) qui guident et encadrent l’examen de toutes les publications de l’IEC pour définir leur utilisation acceptable et déterminer si des révisions ou amendements sont nécessaires. Les examens au titre de la maintenance des livrables sont régis par un ensemble d’indicateurs qui établissent la pertinence et l’application de la norme analysée. Ceux-ci incluent le degré d’adoption de la publication ou son adoption future sous la forme d’une norme nationale, son utilisation par les comités nationaux sans qu’elle soit adoptée à l’échelon national, ou pour des produits fabriqués ou utilisés conformément à la publication, la question de savoir si la réglementation nationale fait référence à la publication ou au document national fondé sur la publication, ainsi que les statistiques de ventes de l’IEC.

Grâce à son processus d’examen systématique (ISO, 2019[16]), l’ISO détermine si ses normes restent valables et sont utilisées au niveau international. Chaque norme est réexaminée au minimum tous les cinq ans, le comité responsable de la norme pouvant engager le processus plus tôt s’il le juge nécessaire. Si le comité n’intervient pas, le scrutin relatif à l’examen systématique est lancé automatiquement à l’échéance des cinq ans. Le formulaire de vote est envoyé à tous les membres de l’ISO et contient une série de questions sur l’utilisation de la norme dans le pays, son adoption nationale ou son utilisation dans la réglementation, ainsi que sa validité technique. Les organismes nationaux de normalisation examinent le document pour déterminer s’il est toujours valable ou s’il devrait être mis à jour ou retiré. L’ISO a publié des orientations spécifiques pour accompagner ce processus d’examen systématique1. Au-delà de sa fonction principale qui est de veiller à ce que l’ensemble de normes ISO reste pertinent et adapté à sa finalité, l’examen systématique permet également la collecte de données. Une partie des informations reçues est intégrée à la base de données ISO/IEC des adoptions nationales qui fournit des indications sur les normes qui ont été adoptées au niveau national – à l’identique ou sous une forme modifiée –, avec les numéros de référence nationaux. Elles forment une ressource essentielle pour suivre l’adoption des normes à l’échelle mondiale.

Dans le cadre du processus d’examen des recommandations (OCDE ; OIML, 2016[17]), les recommandations et documents de l’OIML sont passés en revue tous les cinq ans à compter de leur date de publication pour déterminer s’ils doivent être confirmés, révisés ou retirés. Les priorités de l’examen périodique des publications de l’OIML sont définies par le Conseil de la présidence et le Secrétariat de l’OIML en consultation avec le Comité de management de l’OIML-CS et approuvées par le Comité international de métrologie légale (CIML). Les publications hautement prioritaires sont soumises à un examen périodique tous les deux ans.

Source : (OCDE, 2021[18]) ; synthèse établie par l’auteur sur la base des modèles de pratiques des OI et des contributions ultérieures des OI.

L’évaluation d’instruments individuels s’étend aussi dans certains cas aux instruments clés ou fondateurs d’une organisation internationale. Les motivations d’une telle évaluation sont évidentes. Ces instruments définissant, inspirant et englobant tout un éventail d’activités de réglementation internationale de l’OI en question, savoir qu’ils sont adaptés à leur finalité est essentiel pour donner une crédibilité et une légitimité à l’organisation, démontrer l’efficacité de son action et promouvoir l’adoption de ses instruments à plus grande échelle. Outre les pratiques présentées dans l’Encadré 3.5, cette forme d’évaluation s’appliquerait également au MEN de l’OIT (Encadré 3.1), à l’examen du processus d’élaboration des normes de l’OCDE (Encadré 3.6), à l’examen des résolutions de l’UICN et à l’évaluation par l’UNESCO de ses conventions culturelles (Encadré 3.2), ainsi qu’aux procédures d’examen des normes mentionnées dans l’Encadré 3.4.

Encadré 3.5. Examen des principaux instruments internationaux

L’examen de l’arrangement de reconnaissance mutuelle du CIPM (BIPM, 2016[19]) – l’un des instruments clés du BIPM – après plus de quinze ans d’existence, a apporté un éclairage sur ce qui fonctionnait bien et ce qui devait être amélioré dans sa mise en œuvre. L’objectif premier de cette évaluation était de faire en sorte que « l’arrangement de reconnaissance mutuel (MRA) des étalons nationaux de mesure et des certificats d’étalonnage et de mesurage émis par les instituts nationaux de métrologie » du Comité international des poids et mesures (CIPM) reste adapté à sa finalité et s’inscrive dans la durée. Cette initiative a donné lieu à plusieurs recommandations du groupe de travail sur la mise en œuvre et le fonctionnement du MRA du CIPM, notamment pour : gérer le niveau de participation aux comparaisons clés (KC), accroître la visibilité des services proposés par aptitudes en matière de mesures et d’étalonnages (CMC) dans la base de données des comparaisons-clés du BIPM, limiter la multiplication des CMC, renforcer l’efficacité des processus d’examen, encourager les États dont les systèmes de métrologie sont en cours de développement à devenir signataires du MRA et à y participer pleinement et les doter des moyens nécessaires à cette fin, améliorer la gouvernance de cet instrument et assurer l’application effective et sans retard des recommandations elles-mêmes.

L’accord de reconnaissance mutuelle de l’ILAC (ILAC, 2015[20]) (MRA ILAC) est un accord multilatéral qui favorise la cohérence entre accords et arrangements régionaux de reconnaissance et peut être considéré comme facilitant l’évaluation des décisions de l’ILAC en matière d’accréditation. Le MRA de l’ILAC établit un lien entre les MRA/MLA des organismes de coopération régionale reconnus. Dans le cadre de cet accord de reconnaissance mutuelle et sur la base de l’évaluation et de la reconnaissance par l’ILAC des MRA/MLA régionaux, l’ILAC délègue ses pouvoirs aux organismes de coopération régionale reconnus pour l’évaluation, la surveillance, la réévaluation et les décisions connexes relatives au statut de signataire des organismes d’accréditation membres à part entière de l’ILAC. Les organismes d’accréditation signataires du MRA ILAC ont été évalués par leurs pairs pour prouver leur compétence, dans le respect des exigences de l’ISO/IEC 17011 – Évaluation de la conformité. Les signataires du MRA de l’ILAC évaluent et accréditent ensuite les organismes d’évaluation de la conformité, parmi lesquels les laboratoires d’étalonnage (au moyen de l’ISO/IEC 17025), les laboratoires d’essais (ISO/IEC 17025), les laboratoires d’analyses médicales (ISO 15189), les organismes d’inspection (ISO/IEC 17020), les organisateurs de programmes d’essais d’aptitude (ISO/IEC 17043) et les producteurs de matériaux de référence (ISO 17034), conformément aux normes internationales applicables. L’intégration de l’ISO/IEC 17011 dans les processus d’évaluation par les pairs de l’ILAC est un point d’intersection entre les dimensions d’évaluation (WG4) et de coordination (WG5) de l’élaboration de la réglementation internationale. Cette démarche pourrait apporter plus de cohérence dans les procédures d’évaluation par les pairs. L’évaluation et l’accréditation des organismes d’évaluation de la conformité au moyen de normes internationales spécifiques dans divers secteurs (ISO/IEC 17025, ISO/IEC 17025, ISO 15189, ISO/IEC 17020, ISO/IEC 17043, ISO 17034) sont d’autres illustrations de ce phénomène et montrent plus généralement la complémentarité entre l’ISO, l’ILAC et l’IEC.

Source : synthèse établie par l’auteur sur la base des modèles de pratiques des OI et des contributions ultérieures des OI.

Certaines OI affichent une ambition à l’échelle de l’organisation toute entière, d’évaluer les effets et la pertinence de leurs instruments et commencent à intensifier leurs efforts en la matière. Les enquêtes menées en 2015 et 2018 auprès des OI montrent que les évaluations de l’ensemble des instruments ne sont pas aussi fréquentes que les évaluations ex post d’instruments pris isolément. Cela dit, un certain nombre d’initiatives ont vu le jour ces dernières années et plusieurs organisations ont procédé récemment à un examen général de tous leurs instruments (Encadré 3.6).

Encadré 3.6. Exemples d’examen par les OI de l’ensemble de leurs instruments ou d’un sous-ensemble thématique d’instruments

Le Groupe directeur ad hoc chargé de réduire les prescriptions administratives (SG-RAR) (OCDE, 2014[11]) de l’OMI a été constitué en 2011 pour passer en revue les prescriptions administratives des instruments obligatoires de l’organisation, en vue de formuler des recommandations sur la manière d’alléger les charges imposées par celles-ci. Cette initiative a donné lieu à un inventaire de ces prescriptions, qui en a recensé 560, ainsi qu’à un vaste processus de consultation publique.

De 2013 à 2019, l’Organisation des Nations Unies pour l’éducation, la science et la culture (UNESCO) a mené une série d’évaluations de ses six conventions culturelles dans le cadre d’une évaluation globale du travail normatif de l’UNESCO dans le domaine de la culture (UNESCO, 2019[21]). L’objectif de ces évaluations était d’émettre des conclusions et des recommandations concernant la pertinence et l’efficacité du travail normatif en s’intéressant particulièrement à son impact sur la législation, les politiques et les stratégies des Parties des conventions. Les évaluations des conventions culturelles portaient plus précisément sur l’apport du travail normatif de l’UNESCO, dont le but est d’aider les États membres dans les processus : i) de ratification (ou d’adhésion/acceptation/approbation) des conventions ; ii) d’intégration des dispositions des conventions dans la législation, les politiques et les stratégies nationales/régionales (stade de l’élaboration des politiques), et iii) de mise en œuvre de la législation, des politiques et des stratégies au niveau national (stade de l’application des politiques). Toutes les évaluations du travail normatif de l’UNESCO ont été demandées par la Direction et intégrées aux plans d’évaluation du Bureau de l’évaluation publiés annuellement dans les rapports du Service d’évaluation et d’audit. Les évaluations ont conduit à la mise en place de cadres de résultats pour les conventions de 2003 et 2005, à la révision des mécanismes de présentation de rapports périodiques (Conventions de 1970, 2003 et 2005), à des stratégies de mobilisation des ressources pour les instruments, à l’amélioration des programmes de développement des capacités et des initiatives de communication relatifs aux différentes conventions, ainsi qu’à des changements dans les méthodes de travail des secrétariats des conventions.

En 2018, l’UICN a publié un examen de l’Impact de ses résolutions sur les actions internationales en faveur de la conservation de la nature (UICN, 2018[22]). Le principal objectif de ce rapport était de mettre en avant certains des effets et influences majeurs d’un sous-ensemble d’instruments de l’UICN – ses 1 305 résolutions – sur la conservation de la nature. Ces effets et influences ont été relevés dans quatre secteurs clés. En premier lieu, les résolutions servent à définir les priorités mondiales en matière de conservation. Sous les auspices de la Stratégie mondiale de conservation établie à Christchurch (Nouvelle-Zélande) en 1980, elles définissent le cadre de l’action nationale en matière de conservation, favorisent la coopération entre organismes publics, communautés rurales et secteur privé et appuient un ensemble de programmes internationaux. Les résolutions servent également de base au développement du droit international de la conservation de la nature, notamment par l’élaboration d’instruments phares (et la création d’organisations internationales à part entière) comme la Convention sur le commerce international des espèces de faune et de flore sauvages menacées d’extinction (CITE) et la Convention sur la diversité biologique (CDB). Elles facilitent l’identification des nouveaux enjeux dans le domaine de la conservation de la nature, par exemple l’élimination progressive du concept de rendement durable maximum pour des espèces particulières et son remplacement par la gestion des écosystèmes, l’étude des interactions entre l’énergie et la conservation et le traitement de la question du commerce et de l’environnement, la conservation des ressources marines, la reconnaissance de l’importance croissante du secteur privé à la fois en termes de contribution et de réponse aux questions environnementales, ainsi que la protection des mangroves. Enfin, les résolutions soutiennent des actions spécifiques sur les espèces et les aires protégées, et notamment l’introduction de quotas relatifs aux espèces touchées par le commerce, la promotion de l’utilisation durable des ressources vivantes sauvages et l’établissement de la Liste des Nations Unies des parcs nationaux et réserves analogues.

En 2016, le Secrétaire Général de l’OCDE a lancé un examen du processus d’élaboration des normes à l’échelle de l’organisation C/MIN(2019)13 (OCDE, 2019[23]). La première phase de l’examen, au cours de laquelle les comités de substance de l’OCDE ont procédé entre autres à une analyse complète de tous les instruments juridiques de l’OCDE, a conduit à l’abrogation d’un premier ensemble de trente-deux instruments juridiques obsolètes. La deuxième phase, en cours, est consacrée à la mise en œuvre des plans d’action normatifs par les comités de substance (examen, révision ou suivi de la mise en œuvre de 134 instruments juridiques) et à l’étude de propositions d’abrogation ou d’élaboration de nouveaux instruments dans certains secteurs.

En cours d’élaboration par un groupe de travail spécialisé, le mécanisme de mesure de la performance (PMM) (OMD, 2020[24]) de l’Organisation mondiale des douanes (OMD) entend apporter un outil d’évaluation qui examinera à l’aide d’un ensemble d’indicateurs clés de performance (KPI), tant qualitatifs que quantitatifs, tous les domaines de compétence des douanes (perception de recettes, facilitation des échanges et compétitivité économique, contrôle, sécurité et protection de la société, etc.) pour évaluer et améliorer l’efficacité et l’efficience organisationnelles mais aussi pour déterminer le degré d’application des outils et conventions de l’OMD au service de la mobilisation de recettes et de la circulation libre et sécuritaire des personnes et des marchandises. Le PMM vise également à mesurer la performance des administrations des douanes pour développer la culture de l’évaluation de ses membres et contribuer à la définition de paramètres pour la planification stratégique et la prise de décisions fondée sur des données probantes. Pour garantir l’efficacité du processus d’élaboration du mécanisme, des consultations sont envisagées avec d’autres parties prenantes et notamment le groupe consultatif du secteur privé (PSCG), les milieux universitaires et les organisations internationales partenaires. Mettant à profit la participation de l’OMD aux travaux du partenariat des OI, l’élaboration du futur PMM de l’OMD adopte les principes d’une évaluation progressive et proportionnée présentés dans ce recueil et entend établir de manière prospective un cadre d’évaluation qui rattache la mise en œuvre, la connaissance et l’utilisation des principaux outils de l’OMD par les membres aux aspects pertinents de la performance organisationnelle des groupes cibles de l’OMD.

Source : Synthèse établie par l’auteur sur la base des modèles de pratiques des OI.

Critères et indicateurs (qualitatifs et quantitatifs) à utiliser pour l’évaluation

Il n’y a pas de méthodologie communément ou fréquemment utilisée par les OI pour mener des évaluations. Les méthodologies d’évaluation de l’impact restent embryonnaires et spécifiques à chaque OI, voire – souvent – aux différentes catégories d’instruments au sein de l’OI (Encadré 3.7) (OCDE, 2016[1]).

Encadré 3.7. Enseignements à tirer des méthodologies d’évaluation appliquées par les OI

CITES : la Résolution Conf.14.8 – examen périodique des espèces (CITES, 2011[25]) définit un cadre méthodologique détaillé pour la conduite d’évaluations périodiques. Ce processus inclut l’établissement d’un calendrier pour l’examen, la sélection d’un sous-ensemble pratique d’espèces de flore ou de faune CITES pour analyse et la nomination de consultants qualifiés pour la réalisation de l’évaluation. Les résultats comprennent obligatoirement un résumé des données sur le commerce, l’état de conservation actuel du sujet concerné, y compris la catégorie UICN de l’espèce, l’inscription actuelle aux annexes CITES et la répartition géographique de l’espèce entre États. Ils peuvent servir de base à l’élaboration de recommandations en vue du changement de statut des espèces.

IAF : lorsqu’il procède à des évaluations, le Forum international d’accréditation (IAF) applique les Exigences ISO/IEC 17011 – Évaluation de la conformité (ISO/CEI, 2017[26]) et les Lignes directrices ISO 19011 pour l’audit des systèmes de management (ISO, 2018[27]). Les premières fournissent des orientations détaillées pour l’évaluation et l’accréditation des organismes d’évaluation de la conformité et les secondes, sur les principes de l’audit, le management d’un programme d’audit et l’évaluation de la compétence des personnes impliquées dans le processus d’audit des systèmes de management.

ISO : tous les ans au mois de juin, le Bureau de gestion technique (TMB) (ISO, 1986[28]) étudie l’ensemble des statistiques ayant trait au processus d’élaboration de normes, y compris celles relatives à l’examen des normes (p. ex. taux de réponse et pourcentage de réponses envoyées dans les délais). En cas de problème, le processus pourra être revu dans sa totalité ou en partie par le TMB ou le Groupe de maintenance des directives (DMT), chargé des directives ISO et du supplément (règles applicables au processus d’élaboration de normes). La DMT peut proposer des modifications des règles, qui doivent ensuite être approuvées par le TMB.

OTIF : le projet de décision sur la veille et l’évaluation des instruments juridiques (OTIF, 2019[29]), future procédure d’évaluation de l’OTIF, fixe un délai de trois ans avant le début du travail de veille et d’évaluation des résultats et répercussions de ses instruments juridiques, afin que celui-ci ait une utilité, demande à ses membres d’assurer l’envoi dans les temps d’informations exhaustives pour réaliser des évaluations efficaces et définit les sources de données qui pourraient être intégrées à l’évaluation (rapports, recherche universitaire, jurisprudence, sondages auprès des États membres, organisations régionales et/ou parties prenantes). Le projet de document précise également les différentes catégories de « parties prenantes » auxquelles les évaluateurs sont encouragés à faire appel – leur expérience, leurs compétences et leurs points de vue pouvant apporter des informations essentielles sur l’application pratique de la réglementation.

OMD : le futur mécanisme de mesure de la performance (PMM) (OMD, 2020[24]) de l’Organisation mondiale des douanes (OMD) examinera à l’aide d’un ensemble d’indicateurs clés de performance (KPI), tant qualitatifs que quantitatifs, quatre aspects de la performance couvrant tous les domaines de compétence des douanes (perception de recettes, facilitation des échanges et compétitivité économique, exécution, sécurité et protection de la société, développement organisationnel, etc.) et l’application des principaux instruments et outils pertinents de l’OMD. Le PMM s’inscrira également dans une dynamique d’impact mondial en établissant une correspondance entre les résultats attendus et les Objectifs de développement durable (ODD), ce qui permettra de mettre en évidence la manière dont les compétences des douanes peuvent contribuer à un avenir durable.

Sur l’ensemble des OI ayant répondu à l’enquête de 2018, treize ont indiqué disposer d’orientations écrites en matière d’évaluation. Certaines OI ont élaboré leurs propres orientations ou politiques internes tandis que d’autres utilisent le Manuel du Groupe des Nations Unies pour l’évaluation (UNEG), groupe interinstitutions qui rassemble les unités chargées de l’évaluation dans le système des Nations Unies (UNEG, 2014[6]). Parmi les autres sources d’orientations écrites sur l’évaluation, on peut citer la bibliothèque de documents de l’UNEG (qui inclut maintenant les lignes directrices pour l’évaluation en période de COVID-19) et le Manuel d’inspection et d’évaluation de la Division de l’inspection et de l’évaluation du Bureau des services de contrôle interne des Nations Unies (OIOS-IED) (UNEG, 2021[30]) (UNEG, 2020[31]) (BSCI-IED, 2014[32]).

Dans les cas exceptionnels où les OI procèdent à une analyse avant l’élaboration d’un instrument international (analyse ex ante), elles le font par exemple au moyen d’une liste de questions qui se posent systématiquement à l’organisme de réglementation ; les résultats de cette analyse peuvent alors être soumis aux États membres pour approbation avant de lancer le processus d’élaboration de la réglementation.

Principaux obstacles à une évaluation effective des instruments internationaux

L’évaluation des instruments internationaux est encore loin d’être systématique dans les OI, car sa mise en œuvre peut être source de difficultés. L’évaluation de l’activité normative est reconnue comme une tâche particulièrement ardue. Les besoins en ressources, la coopération avec les groupes intéressés, la culture de l’organisation et la capacité à exploiter les résultats de l’évaluation, mais aussi l’évaluation de l’impact des instruments, le type d’instrument ou son ancienneté sont autant d’aspects qui peuvent poser problème.

L’un des principaux défis réside dans le fait que l’évaluation est grande consommatrice de ressources. Cette difficulté touche toutes les OI, mais celles qui sont dotées de secrétariats de plus petite envergure et de ressources limitées peuvent en ressentir plus intensément les effets. Elle concerne à la fois les ressources quantitatives (temps et argent) et qualitatives (compétences). L’expertise, en particulier, peut être très coûteuse si elle n’est pas disponible en interne et une analyse coûts-avantages peut alors être nécessaire pour déterminer si l’évaluation se justifie (OCDE, 2016[1]).

Certaines difficultés rencontrées dans l’évaluation des instruments peuvent également s’expliquer par le rôle respectif des OI et de leurs groupes cibles. En général, les OI doivent disposer d’un mandat de leurs membres pour entreprendre une activité d’évaluation, mais cela n’est pas toujours simple, du fait de la dynamique qui existe entre les organes directeurs et les membres et des intérêts très divers de ces derniers. Les organes directeurs chargés de l’instrument doivent jouer un rôle central dans l’évaluation, notamment pour veiller à ce que les recommandations soient suivies d’effets. Cela dit, il peut être difficile d’arriver à un consensus entre organes directeurs et membres de l’OI sur les aspects à évaluer, l’étendue de l’évaluation et l’élaboration de recommandations spécifiques. Par ailleurs, l’hétérogénéité des membres de l’OI peut se traduire par des besoins et des capacités – et donc des objectifs – très différents. On peut noter par exemple un degré d’engagement très variable des États membres et associés dans l’accord de reconnaissance mutuelle du CIPM (Encadré 3.5), dû aux besoins plus ou moins importants de leurs économies et à leurs capacités techniques et scientifiques extrêmement diverses. Les pays dotés de systèmes de métrologie avancés privilégient les compétences de plus haut niveau, tandis que les pays et économies où ces systèmes sont tout récents mettent l’accent sur la fourniture de services de base. Il est parfois possible de surmonter ces difficultés en organisant de vastes consultations et en ayant recours à une procédure itérative aboutissant à un consensus autour d’objectifs généraux communs.

Le développement de l’évaluation des instruments internationaux se heurte aussi à des obstacles d’ordre culturel. Les OI peuvent avoir des réticences liées au fait qu’une évaluation qui ne donnerait pas de bons résultats les contraindrait à publier des conclusions négatives. Ce sujet sensible peut être transformé en un message positif sur l’intérêt de l’évaluation grâce à une prise de conscience plus aiguë des avantages que celle-ci peut procurer aux OI et à leurs membres, notamment si les OI montrent que la qualité et l’efficacité de leurs instruments se sont améliorées après une évaluation initialement décevante ou défavorable. Une stratégie gagnante qui permettrait aux OI de limiter les obstacles de ce type consiste à communiquer le bon message sur l’évaluation, autrement dit à la présenter comme un moyen d’analyser l’efficacité de leurs instruments et non comme un examen et une comparaison des performances de leurs membres au regard de ces instruments.

Les OI peuvent également rencontrer des difficultés dans l’exploitation des résultats des évaluations, ce qui signifie que même si l’évaluation en elle-même peut avoir lieu, elles n’en retireront pas forcément tous les avantages. Si la mise en œuvre des recommandations découlant d’une évaluation requiert l’utilisation de nouvelles technologies (en particulier informatiques), par exemple, il se peut que les infrastructures adéquates ou les ressources nécessaires fassent défaut.

Pour ce qui est de l’évaluation de l’impact, la mesure et l’évaluation des effets de l’activité normative internationale posent d’importantes difficultés méthodologiques en raison d’un champ d’application potentiellement diffus et du problème de l’établissement de la causalité (attribution de certains effets aux instruments internationaux). Les instruments internationaux manquent souvent d’outils permettant d’évaluer à la fois des données quantitatives et qualitatives, ce qui limite la compréhension de toute l’étendue et toute la complexité des résultats obtenus (ou les raisons de leur absence). Il peut être particulièrement difficile pour les secrétariats des OI de recueillir les données nécessaires à l’évaluation de l’impact car ce sont essentiellement leurs membres qui détiennent ces informations. Même lorsque ces derniers sont disposés à les communiquer, des problèmes d’ordre pratique peuvent se poser.

En ce qui concerne le type d’instruments, il apparaît que les instruments non contraignants peuvent être plus délicats à évaluer que les instruments obligatoires (voir chapitre 1) car ils sont généralement plus souples et peuvent être mis en œuvre de manière moins homogène.

Enfin, l’ancienneté d’un instrument est un facteur qui peut rendre difficile l’examen simultané de sa mise en œuvre et de son impact lors d’une évaluation. Cette remarque concerne en particulier les instruments récents pour lesquels l’OI s’efforce simplement d’obtenir un nombre de ratifications suffisant. Pour remédier à cela, les évaluations doivent prendre en considération la maturité des instruments et fixer d’emblée des objectifs réalistes.

Pratiques novatrices pouvant contribuer à surmonter les obstacles à l’évaluation rencontrés par les OI

Dans l’ensemble, bien que l’évaluation des instruments internationaux reste relativement limitée, la multiplication des initiatives en la matière contribue progressivement à une meilleure connaissance et compréhension de la mise en œuvre et des répercussions des instruments internationaux. Cette expérience croissante et l’apparition de nouveaux outils issus des technologies de l’information offrent aux OI des possibilités supplémentaires de recueillir et de traiter d’importantes quantités de données et d’informations sur la mise en œuvre, voire l’impact des instruments internationaux et de les communiquer de manière plus fluide aux parties intéressées – que ce soit entre les pays et les secrétariats des OI ou entre les OI elles-mêmes – pour qu’elles puissent utiliser des informations communes.

Encadré 3.8. Pratique de l’évaluation au sein des OI et utilisation d’outils numériques à l’appui de l’évaluation

L’UNESCO indique que la première de ses évaluations du travail normatif de l’UNESCO dans le domaine de la culture (UNESCO, 2013[33]) a fonctionné de fait comme une phase pilote s’agissant de l’évaluation des instruments normatifs. Elle a été produite en parallèle avec le Manuel du Groupe d’évaluation des Nations Unies (UNEG) pour la conduite de l’évaluation du travail normatif dans le système des Nations Unies (UNEG, 2013[34]) et s’en est inspirée. Ce manuel s’appuie sur l’expérience accumulée par les évaluateurs du réseau d’agences des Nations Unies pour fournir un cadre complet en matière d’évaluation, expliquant dans le détail comment déterminer l’évaluabilité du travail normatif, préparer l’évaluation (y compris l’identification des parties prenantes, le but général et les critères et indicateurs), collecter et analyser les données, établir le rapport d’évaluation et donner suite à l’évaluation. Plus généralement, les enseignements tirés de l’évaluation initiale ont été intégrés aux évaluations suivantes, par la pratique vivante et la mise en œuvre de réformes conformément aux termes de référence applicables aux évaluations au sein de l’UNESCO.

L’Organisation des Nations Unies pour l’alimentation et l’agriculture (FAO) a mis en place et tient à jour la base de données FAOLEX (FAO, 2020[35]) qui contient les législations et politiques nationales ainsi que les accords bilatéraux sur l’alimentation, l’agriculture et la gestion des ressources naturelles. Gérée par le Service Droit du développement (LEGN) du Bureau juridique de la FAO, elle peut constituer la base d’un inventaire thématique dans le cadre du mandat de la FAO. FAOLEX est une base de données complète qui inclut les documents juridiques et stratégiques de plus de 200 pays, territoires et organisations d’intégration économique (avec 8 000 nouvelles entrées par an) ; elle propose par ailleurs des ensembles thématiques de données classées par sujet et des profils par pays fournissant un aperçu des politiques et de la législation nationales ainsi que des accords internationaux en vigueur. Cette initiative est une illustration concrète du lien qui existe entre suivi (WG2) et évaluation (WG4), la qualité et l’étendue du premier déterminant la capacité à mener à bien la seconde. Elle montre également le potentiel des nouvelles technologies, dont l’usage réduit les obstacles administratifs, économiques et informationnels à la réalisation d’évaluations effectives.

Source : (OCDE, 2020[36]), Synthèse établie par l’auteur sur la base des modèles de pratiques des OI.

Dans le cadre de l’évaluation ex ante et ex post, les organismes nationaux de régulation recueillent des données importantes qui peuvent combler le manque d’informations des secrétariats des OI sur l’impact de leurs instruments. Une étude du Comité de la politique de la réglementation de l’OCDE menée en 2017 a montré qu’un tiers des pays membres de l’OCDE examinent la mise en œuvre des instruments internationaux auxquels ils adhèrent, et sur ces derniers, six communiquent les résultats de ces évaluations aux OI concernées (OCDE, 2018[37]). Dans l’enquête de 2018, douze OI ont indiqué tenir compte dans certains cas des résultats de l’évaluation nationale des instruments internationaux transposés dans la législation interne.

Références

[19] BIPM (2016), Recommendations from the Working Group on the Implementation and Operation of the CIPM MRA, https://www.bipm.org/utils/common/documents/CIPM-MRA-review/Recommendations-from-the-WG.pdf.

[32] BSCI-IED (2014), OIOS-IED Inspection and Evaluation Manual, https://oios.un.org/sites/oios.un.org/files/images/oios-ied_manual.pdf (accessed on 26 March 2021).

[25] CITES (2011), Résolution Conf. 14.8 - Examen périodique des espèces inscrites aux Annexes I et II, https://cites.org/sites/default/files/document/F-Res-14-08-R17_0.pdf.

[10] Commission européenne (2016), Accord interinstitutionnel « Mieux légiférer » de l’Union européenne, https://eur-lex.europa.eu/legal-content/fr/TXT/?uri=CELEX%3A32016Q0512%2801%29.

[35] FAO (2020), Base de données FAOLEX, http://www.fao.org/faolex/fr/.

[14] https: et al. (2020), ASTM Regulations Governing Technical Committees - Green Book, https://www.astm.org/Regulations.html#s10.

[9] ILAC (2019), Structure of the ILAC Mutual Recognition Arrangement and Procedure for Expansion of the Scope of the ILAC Arrangement (ILAC - R6:05/2019), https://ilac.org/?ddownload=122555.

[20] ILAC (2015), ILAC Mutual Recognition Agreement (ILAC MRA), https://ilac.org/ilac-mra-and-signatories/.

[16] ISO (2019), Guidance on the Systematic Review Process, https://www.iso.org/files/live/sites/isoorg/files/store/en/PUB100413.pdf.

[27] ISO (2018), ISO 19011:2018 Lignes directrices pour l’audit des systèmes de management, https://www.iso.org/fr/standard/70017.html.

[28] ISO (1986), Bureau de gestion technique (ISO/TMB), https://www.iso.org/committee/4882545.html/.

[15] ISO/CEI (2018), Directives ISO/IEC, Partie 1 + Supplément ISO consolidé, https://isotc.iso.org/livelink/livelink/fetch/2000/2122/4230450/4405363/11154417/Suppl%C3%A9ment_ISO_consolid%C3%A9_%289%C3%A8me_%C3%A9dition%2C_2018%29_Format_PDF.pdf?nodeid=19891234&vernum=-2.

[26] ISO/CEI (2017), ISO/IEC 17011: 2017 Évaluation de la conformité — Exigences pour les organismes d’accréditation procédant à l’accréditation d’organismes d’évaluation de la conformité, https://www.iso.org/fr/standard/67198.html.

[18] OCDE (2021), International Regulatory Cooperation and International Organisations: The Case of ASTM International, https://community.oecd.org/servlet/JiveServlet/previewBody/182502-102-1-322490/GOV%20RPC%202020%2017%20IRC%20and%20IOs%20the%20case%20of%20ASTM%20international.pdf (accessed on 3 November 2020).

[3] OCDE (2020), Analyse d’impact de la réglementation, Principes de bonne pratique de l’OCDE en matière de politique réglementaire, Éditions OCDE, Paris, https://dx.doi.org/10.1787/6ee941af-fr.

[36] OCDE (2020), OECD Study on the World Organisation for Animal Health (OIE) Observatory: Strengthening the Implementation of International Standards, Éditions OCDE, Paris, https://dx.doi.org/10.1787/c88edbcd-en.

[5] OCDE (2020), Principes de bonne pratique de l’OCDE en matière de politique réglementaire : Examiner la réglementation existante, Éditions OCDE, Paris, https://www.oecd.org/fr/gov/politique-reglementaire/examiner-la-reglementation-existante-eb656b8d-fr.htm (accessed on 25 March 2021).

[13] OCDE (2019), Better Regulation Practices across the European Union, Éditions OCDE, Paris, https://dx.doi.org/10.1787/9789264311732-en.

[23] OCDE (2019), Examen du processus d’élaboration des normes, Éditions OCDE, Paris, https://one.oecd.org/document/C/MIN(2019)13/fr/pdf.

[4] OCDE (2019), The Contribution of International Organisations to a Rule-Based International System: Key Results from the Partnership of International Organisations for Effective Rulemaking, https://www.oecd.org/gov/regulatory-policy/IO-Rule-Based%20System.pdf.

[37] OCDE (2018), Politique de la réglementation : Perspectives de l’OCDE 2018, Éditions OCDE, Paris, https://dx.doi.org/10.1787/9789264305458-fr.

[38] OCDE (2016), International Regulatory Co-operation: The Role of International Organisations, Éditions OCDE.

[1] OCDE (2016), International Regulatory Co-operation: The Role of International Organisations in Fostering Better Rules of Globalisation, Éditions OCDE, Paris, https://dx.doi.org/10.1787/9789264244047-en.

[11] OCDE (2014), International Regulatory Co-operation and International Organisations: the Cases of the OECD and the IMO, Éditions OCDE, Paris, https://dx.doi.org/10.1787/9789264225756-en.

[7] OCDE (2014), International Regulatory Co-operation and International Organisations: The Cases of the OECD and the IMO, Éditions OCDE, Paris, https://dx.doi.org/10.1787/9789264225756-en.

[17] OCDE ; OIML (2016), International Regulatory Co-operation and International Organisations: The Case of the International Organization of Legal Metrology (OIML).

[12] OIML (1955), Convention instituant une Organisation Internationale de Métrologie Légale, https://www.oiml.org/fr/files/pdf_b/b001-f68.pdf.

[8] OIT (2011), Standards Review Mechanism (SRM), https://www.ilo.org/global/about-the-ilo/how-the-ilo-works/departments-and-offices/jur/legal-instruments/WCMS_712639/lang--en/index.htm.

[24] OMD (2020), Mécanisme de mesure de la performance de l’OMD, http://www.wcoomd.org/fr/wco-working-bodies/capacity_building/working-group-on-performance-measurement.aspx.

[29] OTIF (2019), Notes explicatives sur le projet de décision sur la veille et l’évaluation des instruments juridiques, http://otif.org/fileadmin/new/2-Activities/2G-WGLE/2Ga_WorkingDocWGLE/2020/LAW-19054-GTEJ2-fde-Explanatory-Notes-on-the-Draft-Decision-text-as-endorsed.pdf.

[2] Parker, D. and C. Kirkpatrick (2012), The Economic Impact of Regulatory Policy: A Literature Review of Quantitative Evidence, Éditions OCDE, Paris, http://www.oecd.org/regreform/measuringperformance (accessed on 21 October 2020).

[22] UICN (2018), Impact des résolutions de l’UICN sur les actions internationales en faveur de la conservation de la nature, https://portals.iucn.org/library/node/47226.

[30] UNEG (2021), UNEG Document Library, http://uneval.org/document/library (accessed on 26 March 2021).

[31] UNEG (2020), Synthesis of Guidelines for UN Evaluation under COVID-19, http://uneval.org/document/detail/2863 (accessed on 26 March 2021).

[6] UNEG (2014), Manuel de l’UNEG pour la conduite de l’évaluation du travail normatif dans le système des Nations Unies, http://www.uneval.org/document/detail/1484 (accessed on 4 December 2020).

[34] UNEG (2013), Manuel de l’UNEG pour la conduite de l’évaluation du travail normatif dans le système des Nations Unies, http://www.uneval.org/document/detail/1484.

[21] UNESCO (2019), Évaluation du travail normatif de l’UNESCO dans le domaine de la culture,, https://unesdoc.unesco.org/ark:/48223/pf0000223095.

[33] UNESCO (2013), Évaluation du travail normatif de l’UNESCO dans le domaine de la culture, Première partie : Convention de 2003 pour la sauvegarde du patrimoine culturel immatériel, https://unesdoc.unesco.org/ark:/48223/pf0000223095.

Notes

← 1. Certaines OI établissent une distinction entre « évaluations internes » (réalisées par un service d’évaluation indépendant faisant partie de l’OI) et « auto-évaluations » (menées directement par le service responsable de l’instrument concerné, pour ses propres besoins). Dans les deux cas, il peut être fait appel à l’assistance de consultants/spécialistes externes, mais c’est toujours l’OI qui guide l’évaluation en interne. Le présent chapitre ne fait pas de différence entre évaluation « interne » et « auto-évaluation », les deux s’appliquant ici.

← 2. Manuel de l’UNEG pour la conduite de l’évaluation du travail normatif dans le système des Nations Unies (2014) www.uneval.org/document/detail/1484.

← 3. Par exemple, le document Better Criteria for Better Evaluation du CAD de l’OCDE (2019) www.oecd.org/dac/evaluation/revised-evaluation-criteria-dec-2019.pdf, le Manuel de l’UNEG pour la conduite de l’évaluation du travail normatif dans le système des Nations Unies (2014) et les Lignes directrices de la Commission européenne sur l’évaluation, https://ec.europa.eu/info/sites/info/files/better-regulation-guidelines-evaluation-fitness-checks.pdf.

← 4. Selon les Perspectives de l’OCDE 2018 – Politique de la réglementation, l’analyse d’impact ex ante de la réglementation (ou évaluation ex ante de l’impact de la réglementation) désigne « le processus systématique d’identification et de quantification des avantages et des coûts susceptibles de découler des options, réglementaires ou non, de l’action gouvernementale envisagée ».

← 5. Pour plus d’informations sur les meilleures pratiques appliquées en matière d’analyse de l’impact, voir la publication de l’OCDE sur l’Analyse d’impact de la réglementation (2020) http://www.oecd.org/gov/regulatory-policy/regulatory-impact-assessment-7a9638cb-en.htm et les Lignes directrices de la Commission européenne sur l’analyse d’impact https://ec.europa.eu/info/sites/info/files/better-regulation-guidelines-impact-assessment.pdf.

← 6. Voir Glossaire.